Verso i Domain Specific Language Models

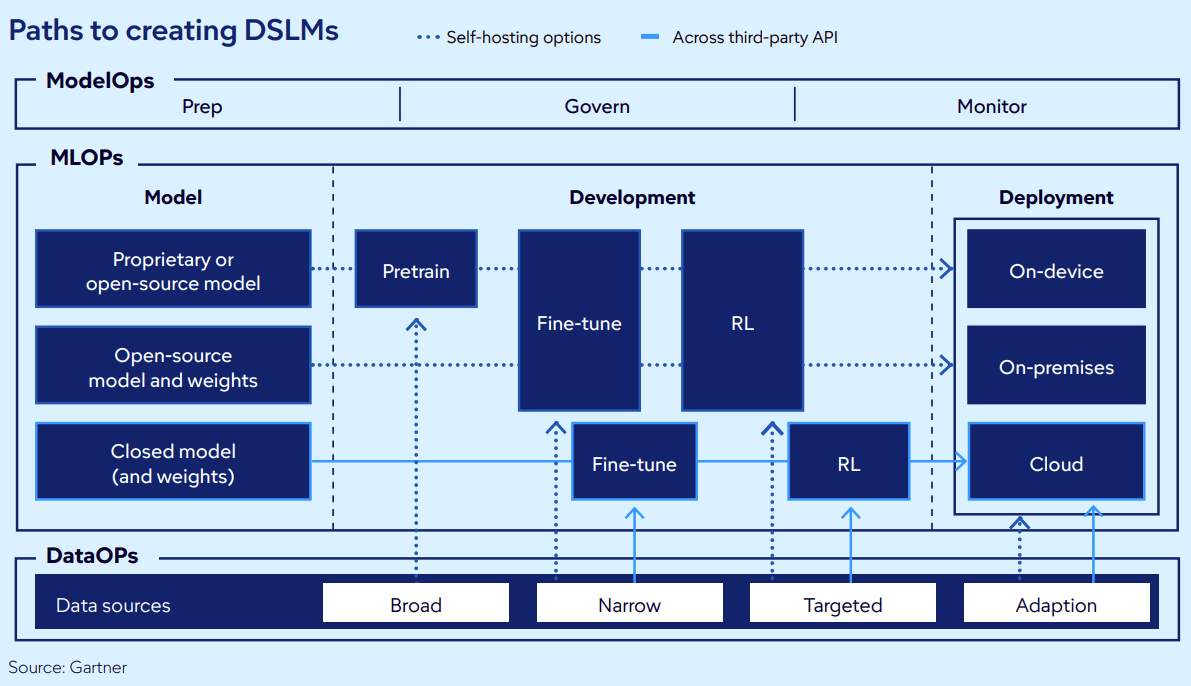

L’evoluzione dell’Intelligenza Artificiale Generativa sta evolvendo dall’approccio “one model fits all” verso soluzioni verticali più precise, primi tra tutti i Domain-Specific Language Model (DSLM), ovvero modelli di IA addestrati o ottimizzati per specializzarsi in un determinato campo, come la medicina, la finanza, la legge o la cybersicurezza. Secondo le proiezioni di Gartner per il 2026, entro il 2028, oltre il 60% dei modelli GenAI enterprise sarà specifico per dominio (Fonte, link esterno).

A differenza dei Large Language Models generalisti (come GPT-4 o Llama), addestrati su vasti dataset eterogenei per coprire un’ampiezza di argomenti quasi infinita, un DSLM privilegia la profondità. I modelli generalisti, con i loro tassi di allucinazione molto alti e costi di inferenza elevati, faticano a scalare in produzione. Al contrario, i DSLM offrono accuratezza superiore e sbloccano nuove architetture di deployment: Gartner stima che il 30% dei carichi di lavoro GenAI girerà su DSLM on-premises o direttamente su dispositivo (on-device) entro il 2028, garantendo privacy e bassa latenza impossibili con le sole API in cloud pubblico.

LLM vs SLM vs DSLM: confronto su architettura e dati

Per progettare l’architettura corretta, è fondamentale distinguere tra le categorie di modelli oggi disponibili, analizzando il trade-off tra dimensioni, dati di training e scopo operativo.

- Large Language Models (LLM). Gli LLM operano come motori general-purpose. Addestrati su petabyte di dati non curati provenienti dal web pubblico (blog, forum, notizie), sono estremamente versatili, ma mancano di affidabilità specifica. Da un punto di vista ingegneristico, comportano costi di training e inferenza elevati e presentano rischi di conformità significativi quando applicati a dati proprietari.

- Small Language Models (SLM). Gli SLM sono versioni compatte dei modelli linguistici, caratterizzate da un numero di parametri significativamente inferiore. Questa architettura ridotta è fondamentale per i Data Engineer che necessitano di bassa latenza: richiedono meno risorse computazionali, riducono i costi infrastrutturali e permettono l’esecuzione locale o su dispositivi mobili (edge computing). Sebbene abbiano una “knowledge base” generalista più limitata, gli SLM rappresentano spesso l’architettura ideale per costruire DSLM efficienti.

- Domain-Specific Language Models (DSLM). Il DSLM può derivare sia da un LLM, sia da un SLM, ma si distingue per il dataset di addestramento: corpus curati e altamente specifici come riviste mediche, contratti o codici proprietari. Questo approccio permette al modello di “parlare la lingua” del settore, comprendendo acronimi e sfumature che un modello generalista perderebbe, ad esempio il termine “container” in ambito logistico o informatico.

| Caratteristica | LLM – Large Language Model | SLM – Small Language Model | DSLM – Domain-Specific Language Model |

| Scopo | Ampia conoscenza, vari task. | Efficienza, velocità, uso locale. | Alta precisione e focus verticale. |

| Dati | Eterogenei e non curati (Web). | Set di dati più piccoli, spesso mirati. | Dati curati, tecnici e proprietari. |

| Dimensioni | Miliardi di parametri, enormi. | Parametri ridotti, compatti. | Variabile (spesso basati su SLM per efficienza). |

| Affidabilità | Alta tendenza alle allucinazioni | Dipende dal training | Allucinazioni ridotte e output deterministico |

| Costo | Molto alto (training e inferenza). | Basso, efficiente energeticamente. | Ottimizzato (ROI migliore per task specifici). |

| Esempio | GPT-4, Llama (base). | Modelli per dispositivi mobili. | Med-PaLM (Medicina), FinGPT (Finanza). |

Creare un DSLM: Training from Scratch, RAG e Fine-Tuning

La creazione di un DSLM è una scelta architetturale che bilancia costi computazionali, controllo sui pesi del modello e necessità di aggiornamento delle conoscenze. Le strategie principali si dividono in approcci strutturali, ovvero come il modello viene costruito, e tecniche di ottimizzazione, ovvero come i parametri vengono aggiornati.

La decisione iniziale riguarda la modalità di costruzione del modello.

- L’addestramento da zero, conosciuto come Training from Scratch, è il più costoso, perché implica la costruzione del modello partendo dalle fondamenta, utilizzando solo dati specifici. Sebbene offra il massimo controllo, richiede risorse di calcolo davvero importanti ed è giustificato solo per casi d’uso critici su larga scala, come dimostrato da BloombergGPT nel settore finanziario.

- All’opposto troviamo la RAG (Retrieval-Augmented Generation), che tecnicamente non modifica i pesi del modello, ma lo collega a una base di conoscenza esterna, ad esempio database vettoriali aziendali. È la soluzione ideale per domini in cui le informazioni cambiano rapidamente, poiché il modello recupera dati pertinenti prima di generare la risposta.

- Il Fine-Tuning rimane l’approccio più comune ed equilibrato per la creazione di DSLM. Si parte da un modello pre-addestrato, come Llama o BERT e lo si adatta su dataset di dominio. Le metodologie per il fine-tuning di un Domain-Specific Language Model si dividono poi in base a quanto del modello viene modificato (tutti i parametri o solo una parte) e come i dati vengono presentati (supervisionati o non supervisionati).

Perché scegliere un DSLM: riduzione delle allucinazioni, costi e compliance

La scelta di implementare un DSLM non è limitata al miglioramento di qualità dell’output, ma risponde a precise esigenze di affidabilità sistemica, costi di gestione e sicurezza dei dati: i DSLM infatti risolvono alcuni punti che impediscono l’adozione dell’IA in ambienti di produzione critici.

Precisione deterministica e riduzione delle allucinazioni

Il vantaggio tecnico più immediato è la stabilità dell’output. In contesti ad alto rischio come la sanità o il trading, le allucinazioni e gli errori degli LLM generalisti sono potenzialmente molto gravi.

I modelli generalisti tendono ad allucinare con tassi che variano dal 12% al 20% in compiti complessi. Ancorando il modello a dataset curati, i DSLM abbattono questo tasso d’errore fino a circa il 2%. Inoltre, garantiscono la comprensione della semantica di settore: un DSLM legale distingue il significato procedurale di “brief” (memoria) dal suo uso comune, eliminando ambiguità che richiederebbero complessi layer di validazione post-processing.

Efficienza e ottimizzazione dei costi

Dal punto di vista dell’infrastruttura, i DSLM presentano efficienza superiore. Eseguire un modello da trilioni di parametri, come GPT-4, per ogni richiesta interna comporta costi di inferenza insostenibili su larga scala.

Poiché i DSLM sono spesso basati su architetture SLM o modelli quantizzati, riducono drasticamente il consumo di risorse computazionali e la latenza e questo permette l’integrazione in flussi di lavoro real-time, dove i tempi di risposta delle API pubbliche sarebbero inaccettabili.

Compliance “By Design” e sovranità dei dati

La conformità normativa è spesso il blocco principale per l’adozione degli LLM pubblici. I DSLM permettono di internalizzare il modello per garantire che i dati sensibili non lascino mai il perimetro aziendale.

È possibile progettare il modello per integrare nativamente framework come GDPR (privacy) o FINRA (finanza). Inoltre, l’addestramento su dati selezionati riduce la probabilità che il modello generi contenuti tossici o distorti, un rischio comune quando si utilizza il web non filtrato come base di conoscenza.

Benchmark e case study DSLM: finanza, sanità e legal

L’adozione dei DSLM sta iniziando ad essere vista dalle aziende che operano in settori critici, come una soluzione che migliora in modo significativo la qualità degli output. I dati sul campo confermano che la verticalizzazione riduce il tasso di errore e ottimizza i processi operativi in modo misurabile. Vediamo qualche esempio.

Finanza: analisi del rischio

Il settore finanziario, caratterizzato dalla necessità di precisione assoluta e conformità normativa, ha guidato l’adozione di modelli “from scratch” e perfezionati.

- BloombergGPT: creato con la tecnica “Training from scratch” e costruito su un corpus proprietario di oltre 50 miliardi di documenti finanziari, questo modello ha dimostrato di ridurre i tassi di errore di oltre il 30% rispetto ai modelli generalisti in task specifici come l’analisi del sentiment e la stesura di report finanziari. Come accennato in precedenza però, le risorse di calcolo richieste dal modello sono talmente estese che il suo utilizzo è giustificato solo per casi critici.

- FinGPT (open source) e Instruct-FinGPT: modelli leggeri creati con la tecnica del fine tuning. Questi modelli, ottimizzati per il rilevamento delle frodi e l’analisi del rischio, hanno permesso alle istituzioni finanziarie di ridurre i casi di frode del 30% rispetto ai sistemi di IA generici. La loro capacità di analizzare report e prevedere rischi di insolvenza supera nettamente i modelli generalisti grazie alla comprensione del gergo tecnico e delle dinamiche di mercato.

Sanità: accuratezza delle diagnosi e supporto clinico

In ambito medico, dove l’allucinazione è inaccettabile e pericolosa, i DSLM hanno raggiunto livelli di competenza pari o superiori agli esperti umani.

- PMC-LLaMA: modello open-source addestrato su 4,9 milioni di articoli medici. Offre prestazioni superiori nel ragionamento biomedico rispetto al modello base, dimostrando l’efficacia del fine-tuning su corpora scientifici open access. A livello operativo, l’uso di questi strumenti ha ridotto i tempi di risposta dei test del 40% e i costi amministrativi fino al 30%.

Legal & Compliance: automazione della document discovery

Gli studi legali stanno iniziando ad utilizzare i DSLM per gestire la complessità semantica e la mole di documenti contrattuali.

- ChatLAW e JurisGPT: strumenti verticali progettati per la “document discovery” e l’analisi contrattuale. A differenza dei modelli generici, mantengono il contesto su documenti lunghi e comprendono le sfumature giuridiche. L’implementazione di questi DSLM ha ridotto i tempi di elaborazione dei contratti del 30% e i costi operativi del 45%, segnalando clausole non conformi in pochi secondi con un tasso di allucinazione molto inferiore rispetto ai modelli generalisti.

L’analisi tecnica e di mercato indica chiaramente che l’era dell’approccio “taglia unica” per l’Intelligenza Artificiale sta volgendo al termine. Nei prossimi anni, l’adozione dell’Intelligenza artificiale sarà guidata da settori che richiedono elevata specializzazione.

Le aziende che sapranno curare i propri dati e perfezionare modelli specifici otterranno un vantaggio competitivo decisivo, misurabile in riduzione dei costi di inferenza, abbattimento dei tassi di allucinazione e garanzia di compliance.