Deep Reinforcement Learning: applicazioni e algoritmi

Il Deep Reinforcement Learning nasce dalla combinazione tra le reti neurali profonde e il Reinforcement Learning, o apprendimento per rinforzo.

Questa unione ha dato vita ad un campo del machine learning che va oltre i confini tradizionali. Il Deep Reinforcement Learning, infatti, permette a un “agente” software di imparare a elaborare strategie complesse, chiamate policy. L’obiettivo è prendere decisioni che portino a massimizzare la ricompensa cumulativa attesa nel tempo.

In pratica, si uniscono la capacità delle reti neurali di interpretare grandi volumi di dati con un metodo di apprendimento orientato a un obiettivo, che permette di prendere decisioni intelligenti. Questo ha innescato un vero e proprio cambiamento nello studio e nella ricerca del Machine Learning e ha aperto la strada a soluzioni per problemi che prima erano considerati irrisolvibili.

Le componenti fondamentali del Reinforcement Learning

Per capire davvero il Deep Reinforcement Learning, dobbiamo fare un passo indietro e conoscere i protagonisti del Reinforcement Learning classico. Possiamo immaginare questi elementi come dei veri e propri mattoncini che costruiscono l’intero framework di apprendimento e decisione. L’interazione tra loro viene spesso formalizzata in un modello matematico noto come Processo Decisionale di Markov.

Immagina il Reinforcement learning come un gioco. Ecco i giocatori e le regole:

- Agente: è il giocatore, l’entità che impara e prende le decisioni. Il suo scopo è agire secondo una strategia e migliorarla nel tempo grazie all’esperienza.

- Environment: è il mondo del gioco, il sistema esterno con cui l’agente interagisce. L’ambiente risponde alle azioni dell’agente con dei feedback.

- Stato: è una fotografia della situazione attuale dell’ambiente in un dato momento. È l’informazione che l’agente usa per decidere cosa fare.

- Azione: è la mossa scelta dall’agente, ovvero la decisione che modifica lo stato dell’ambiente.

- Ricompensa: è il punteggio, un segnale numerico che l’ambiente restituisce dopo un’azione. Indica quanto è stata “buona” la mossa e guida l’agente verso i comportamenti desiderati. L’obiettivo finale dell’agente è massimizzare la somma totale delle ricompense che si aspetta di ricevere.

Oltre agli elementi “fisici”, ci sono dei concetti astratti che definiscono come l’agente impara e si comporta:

- Policy: la strategia, il “piano di gioco” che l’agente segue per mappare gli stati alle azioni. L’intero processo di apprendimento è volto a trovare la policy ottimale, quella che garantisce la massima ricompensa cumulativa.

- Funzione di valore: calcola la ricompensa totale attesa che un agente può ottenere partendo da un certo stato e seguendo una data policy. In parole semplici, aiuta l’agente a valutare quanto sia promettente una certa situazione.

- Strategia Esplorazione-Sfruttamento: uno dei dilemmi centrali dall’apprendimento con rinforzo. L’agente deve sempre scegliere se esplorare nuove azioni per scoprire se possano portare a ricompense migliori, oppure sfruttare le azioni che già conosce per ottenere un guadagno sicuro e immediato. Trovare il giusto equilibrio è fondamentale per un apprendimento efficace.

> Leggi anche: “Tipologie e Algoritmi di Machine Learning”

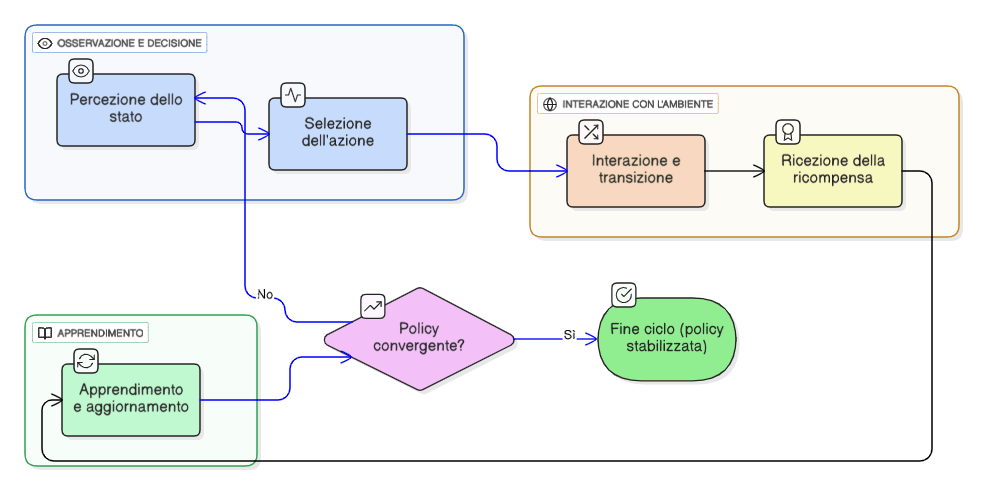

Il ciclo di apprendimento iterativo del Deep Reinforcement Learning

La vera innovazione del Deep Reinforcement Learning è un ciclo di feedback continuo tra l’agente e il suo ambiente. A differenza dell’apprendimento supervisionato, che necessita di dati già etichettati, un agente di Deep Reinforcement Learning impara in modo molto più autonomo, attraverso tentativi ed errori (trial and error). L’intero processo si basa sull’interazione diretta per scoprire quali sequenze di azioni portano a massimizzare le ricompense nel lungo termine.

Questo ciclo di apprendimento si sviluppa attraverso una serie di passaggi che si ripetono costantemente:

- Percezione dello stato: all’inizio di ogni ciclo, l’agente osserva lo stato attuale dell’ambiente. Questo “stato” può essere qualsiasi cosa, da una semplice coordinata a un input sensoriale grezzo.

- Selezione dell’azione: sulla base dello stato osservato, l’agente consulta la sua policy per decidere quale azione compiere. In questa fase, l’agente dovrà scegliere tra l’esplorazione (provare nuove azioni) e lo sfruttamento (usare azioni che sa già essere efficaci).

- Interazione e transizione: l’azione scelta viene eseguita nell’ambiente, provocando una modifica del sistema. In altre parole, l’ambiente passa in uno stato diverso da quello precedente.

- Ricezione della ricompensa: Insieme al nuovo stato, l’ambiente invia all’agente un feedback: una ricompensa numerica che indica quanto è stata desiderabile l’azione appena compiuta.

- Apprendimento e aggiornamento: l’agente registra l’intera esperienza (stato iniziale, azione, ricompensa, nuovo stato) e la utilizza per aggiornare la sua policy o la sua funzione di valore. È questo il momento in cui avviene l’apprendimento vero e proprio, affinando la strategia per le decisioni futuro.

Questo ciclo continua finché la policy dell’agente non smette di migliorare in modo significativo e si stabilizza, un processo noto come convergenza.

> Leggi anche: “IA Agentica: applicazioni e rischi degli agenti autonomi”

Reti Neurali e Reinforcement Learning

A questo punto è naturale chiedersi perché stiamo parlando di “Deep” Reinforcement Learning? La risposta sta nella scala e nella complessità dei problemi che possiamo risolvere.

Mentre i metodi tradizionali di apprendimento con rinforzo funzionano bene in ambienti semplici, falliscono quando lo spazio degli stati è troppo vasto o continuo. Immagina di dover creare una tabella per ogni possibile configurazione di pixel su uno schermo: sarebbe impossibile. È qui che entrano in gioco le Reti Neurali Profonde.

> Scopri anche il corso di Reti Neurali

Nel Deep Reinforcement Learning, le reti neurali profonde agiscono come approssimatori di funzioni (function approximators). In parole semplici, imparano a stimare le funzioni complesse che l’agente deve ottimizzare. Svolgono principalmente due ruoli:

- Policy Network: è una rete neurale che impara direttamente la policy. Il suo compito è prendere in input uno stato e restituire l’azione migliore da compiere (o una distribuzione di probabilità sulle azioni possibili).

- Value Network: è una rete neurale che approssima la funzione di valore. Invece di decidere un’azione, stima il rendimento cumulativo atteso partendo da un certo stato o da una coppia stato-azione.

La vera innovazione delle reti neurali nel Deep Reinforcement Learning è la loro capacità di estrarre caratteristiche complesse direttamente da input sensoriali grezzi. Questo significa che un agente può imparare a giocare a un videogioco guardando direttamente i pixel dello schermo, senza che un programmatore debba dirgli come riconoscere oggetti, personaggi o punteggi. Questa abilità di apprendere senza un feature engineering manuale è ciò che permette al deep reinforcement learning di affrontare problemi del mondo reale in tutta la loro complessità.

Le principali categorie di algoritmi Deep Reinforcement Learning

Gli algoritmi sono le strutture matematiche che definiscono il processo di apprendimento dell’agente. A seconda della strategia che adottano per trovare la policy ottimale, si dividono in alcune famiglie principali.

Metodi Basati sul Valore (Value-Based)

Questi metodi si concentrano sull’imparare a stimare con precisione la Funzione di Valore, che predice la ricompensa totale attesa per ogni coppia stato-azione (Chiamiamo questo valore Q). La policy non viene appresa direttamente, ma derivata in modo indiretto: l’agente sceglie semplicemente l’azione che ha il valore Q più alto in un dato stato (una policy definita greedy).

Deep Q-Network è l’algoritmo che ha imparato a giocare con i giochi Atari direttamente dai pixel grezzi dello schermo. Si utilizza principalmente per spazi di azione discreti, dove il numero di azioni possibili è limitato.

Metodi Basati sulla Policy (Policy Gradient)

Questi metodi ottimizzano direttamente la policy: la rete neurale viene addestrata per mappare gli stati direttamente alle azioni e i suoi parametri vengono aggiornati tramite una tecnica chiamata ascesa del gradiente.

REINFORCE è uno dei primi e più fondamentali algoritmi di questa categoria, spesso chiamato anche Monte Carlo Policy Gradient. Viene principalmente utilizzato in spazi di azione continui o ad alta dimensionalità, come quelli che si incontrano nel controllo robotico, dove elencare tutte le possibili azioni sarebbe impossibile.

Sistemi Ibridi (Actor-Critic)

Questi metodi, molto popolari ed efficaci, combinano i vantaggi degli approcci basati sul valore e sulla policy. L’architettura è divisa in due:

- L’Actor (attore): è una rete basata sulla policy che decide quale azione intraprendere.

- Il Critic (critico): è una rete basata sul valore che valuta l’azione scelta dall’Actor e gli fornisce un segnale di training per migliorare.

Questo approccio ibrido permette di ridurre la varianza e stabilizzare l’apprendimento. Alcuni esempi sono: PPO (Proximal Policy Optimization), SAC (Soft Actor-Critic), DDPG (Deep Deterministic Policy Gradient).

Metodi Basati su Modello (Model-Based)

Infine, una categoria a parte è quella degli algoritmi che apprendono un modello esplicito dell’ambiente per simulare i risultati futuri e pianificare le mosse. Questo li rende potenzialmente molto più efficienti in termini di dati richiesti (sample-efficient).

Esempi sono AlphaZero e MuZero, famosi per aver raggiunto prestazioni incredibili in giochi strategici complessi come Go, scacchi e Shogi.

Applicazioni nel Mondo Reale

Il Deep Reinforcement Learning è molto più di un affascinante concetto accademico; è uno strumento di trasformazione che permette di affrontare un’ampia gamma di problemi complessi: la sua evoluzione gli ha permesso di essere applicato in situazioni reali ad alto impatto. Vediamo di seguito alcuni esempi.

Robotica e sistemi autonomi

Il deep reinforcement learning è diventato essenziale per i sistemi che interagiscono con il mondo fisico.

- Automazione industriale: i robot possono acquisire abilità avanzate come la navigazione, l’identificazione di oggetti e la manipolazione di precisione, trovando applicazione nella produzione manifatturiera.

- Veicoli autonomi e droni: la tecnologia è fondamentale per lo sviluppo di veicoli autonomi (self-driving cars) e droni, permettendo loro di imparare a prendere decisioni di guida sicure e intelligenti.

- Controllo continuo: il deep reinforcement learning eccelle in compiti che richiedono una sequenza di azioni continue, come le attività di manipolazione eseguite da bracci robotici.

Finanza e Trading

Nei mercati finanziari, il deep reinforcement learning viene utilizzato per ottimizzare le decisioni in ambienti estremamente dinamici.

- Strategie di trading: permette di ottimizzare le tattiche di trading, la gestione del portafoglio e la valutazione del rischio.

- Decisioni ad alta frequenza: supporta il processo decisionale ad alta frequenza (high-frequency decision-making), automatizzando aspetti del trading elettronico.

Sanità e Medicina

L’applicazione del DRL in ambito sanitario è un’area di ricerca in continua crescita.

- Piani di trattamento personalizzati: aiuta a sviluppare piani di trattamento individualizzati per i pazienti.

- Ricerca e diagnosi: contribuisce alla scoperta di nuovi farmaci e assiste nella diagnosi di malattie attraverso l’analisi di immagini mediche.

- Chirurgia di precisione: i bot addestrati con l’apprendimento con rinforzo possono eseguire interventi chirurgici che richiedono un’altissima precisione.

- Biologia strutturale: un esempio notevole, sebbene ibrido, è AlphaFold di DeepMind, che ha raggiunto una precisione quasi sperimentale nella previsione della struttura delle proteine.

Ottimizzazione Industriale ed Energetica

Il DRL viene impiegato per migliorare l’efficienza dei processi su larga scala.

- Gestione energetica: ottimizza l’uso dell’energia, la gestione della rete (grid management) e la distribuzione delle risorse rinnovabili.

- Efficienza dei data center: è stato utilizzato con successo per controllare il sistema di raffreddamento dei data center di Google, migliorandone notevolmente l’efficienza energetica.

- Supply Chain: ottimizza i processi di produzione e la gestione della catena di approvvigionamento (supply chain management).

Sistemi di Informazione e Linguaggio

- Sistemi di raccomandazione: migliora i suggerimenti personalizzati nell’e-commerce, nello streaming di contenuti e nella pubblicità, imparando le preferenze degli utenti e adattandosi in tempo reale. Un framework basato su DQN è stato proposto per la raccomandazione di notizie online, considerando sia la ricompensa immediata che quella futura.

- Elaborazione del linguaggio naturale (NLP): fa progredire i sistemi di dialogo, la traduzione automatica e la produzione di testo. La tecnologia viene applicata anche per affinare i Large Language Models (LLMs).

La capacità del DRL di adattarsi a situazioni dinamiche e di apprendere da dati non elaborati lo rende uno strumento in grado di plasmare la direzione della tecnologia e di risolvere problemi pratici complessi.

Dalla robotica alla finanza, fino alla sanità, le sue applicazioni stanno già plasmando la direzione della tecnologia moderna, offrendo soluzioni innovative a sfide prima considerate insormontabili. Per le aziende che puntano a innovare e a mantenere un vantaggio competitivo, comprendere e saper applicare il DRL è ma una competenza strategica fondamentale per il futuro.

> Scopri il catalogo corsi dedicato all’intelligenza artificiale e al machine learning engineering

Fonti

Baheti, P. (2021). Deep Reinforcement Learning: Definition, Algorithms & Uses. Www.v7labs.com. https://www.v7labs.com/blog/deep-reinforcement-learning-guide

GeeksforGeeks. (2023). A Beginner’s Guide to Deep Reinforcement Learning. GeeksforGeeks. https://www.geeksforgeeks.org/artificial-intelligence/a-beginners-guide-to-deep-reinforcement-learning/

Joo, J. (2023). Deep reinforcement learning. Domino.ai; Domino. http://domino.ai/blog/deep-reinforcement-learning

Plaat, A. (2022). Deep reinforcement learning (Vol. 10, pp. 978-981). Singapore: Springer.

Sun, Y., Wang, H., Chen, H., & Zhang, W. (2025). A Practical Introduction to Deep Reinforcement Learning. arXiv preprint arXiv:2505.08295.

Terven, J. (2025). Deep reinforcement learning: a chronological overview and methods. AI, 6(3), 46.